Искусство и науку повышения рейтинга вашего сайта в различных поисковых системах обычно называют SEO (поисковая оптимизация). И когда дело доходит до SEO, существует множество различных аспектов, возможно, слишком много, чтобы охватить их в одной статье. Вот почему мы сосредоточимся только на одном – robots.txt WordPress. В этой статье подробнее рассмотрим, что такое robots.txt и как его использовать, обсудим различные способы создания файла и рассмотрим лучшие практики в отношении его директив.

Что такое «robots.txt»

Robots.txt – это текстовый файл, расположенный в корневом каталоге WordPress. К нему можно получить доступ из браузера, открыв URL-адрес your-website.com/robots.txt. Он позволяет ботам поисковых систем знать, какие страницы сайта следует сканировать, а какие нет. Строго говоря, веб-сайту не нужен robots.txt. Если вы находитесь в процессе создания своего веб-сайта, лучше сначала сосредоточиться на создании качественного контента. Боты поисковых систем будут сканировать вебсайт независимо от того, есть ли у вас robots.txt или нет.

Более того, хорошо написанные директивы WordPress robots.txt могут уменьшить негативные последствия плохих ботов, запретив им доступ. Это, в свою очередь, улучшит общую скорость загрузки сайта. Но имейте в виду, что директивы robots.txt не должны быть единственной защитой. Плохие боты часто игнорируют их, поэтому настоятельно рекомендуется использовать хороший плагин безопасности, особенно если на веб-сайте возникают проблемы, вызванные плохими ботами.

Наконец, распространено заблуждение, что robots.txt предотвратит индексацию некоторых страниц веб-сайта. Файл robots.txt может содержать директивы, запрещающие сканирование, но не индексирование. И даже если страница не просканирована, ее все равно можно проиндексировать с помощью внешних ссылок, ведущих на нее. Если вы хотите избежать индексации определенной страницы, следует использовать метатег noindex вместо директив в robots.txt для WordPress.

Как использовать «robots.txt»

Уяснив, что такое robots.txt в WordPress и что он делает, рассмотрим, как он используется. Из этого раздела вы узнаете, как создать и отредактировать robots.txt, некоторые передовые практики в отношении его содержания и как проверить его на наличие ошибок.

По умолчанию WordPress создает виртуальный robots.txt для любого веб-сайта. Он может выглядеть примерно так:

Смотрите также:

Как закрыть сайт от индексации и что это означает

Но если вы захотите его отредактировать, нужно создать настоящий robots.txt. Ниже описаны три способа, как это сделать. Два из них предполагают использование плагинов WordPress, а третий полагается на использование FTP.

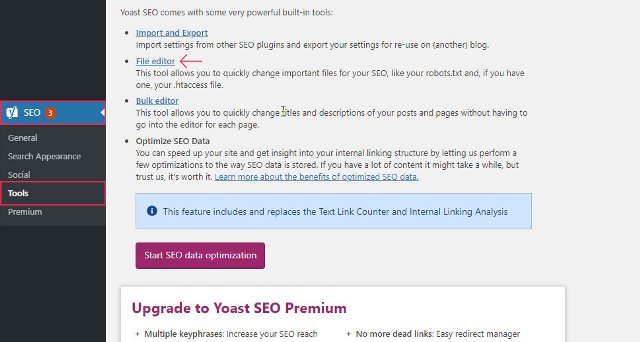

Yoast SEO

Плагин Yoast SEO – один из самых популярных доступных плагинов для SEO с более чем 5 миллионами активных установок. Он включает множество инструментов для оптимизации сайта, в том числе функцию для создания и редактирования robots.txt для WordPress.

После установки плагина, нажмите на вновь созданный SEO раздел, а затем кликните на подраздел Инструменты. На открывшейся странице щелкните ссылку Редактор файлов вверху.

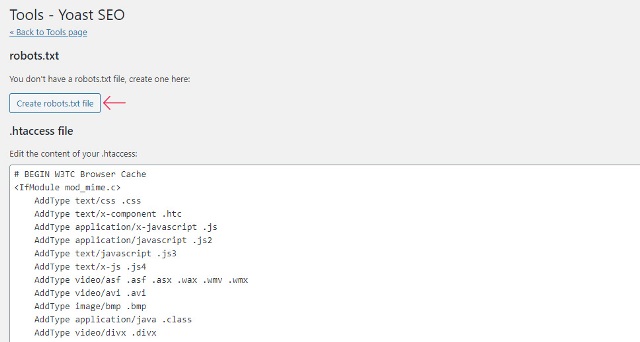

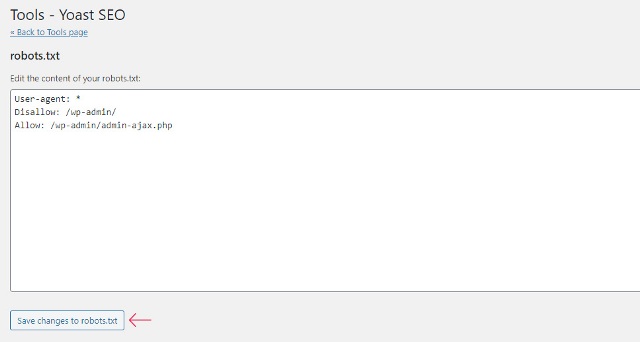

На следующей странице найдите раздел robots.txt. Оттуда, если не создали файл раньше, следует нажать кнопку Создать robots.txt.

Это действие создаст файл, и теперь можно увидеть его содержимое в текстовой области. Используя ту же текстовую область, можно редактировать содержание нового robots.txt. Закончив редактирование, нажмите кнопку Сохранить изменения в robots.txt ниже.

All in one SEO

All in one SEO – еще один очень популярный плагин SEO, который поставляется с различными бесплатными функциями, в том числе возможностью создавать и редактировать robots.txt для WordPress.

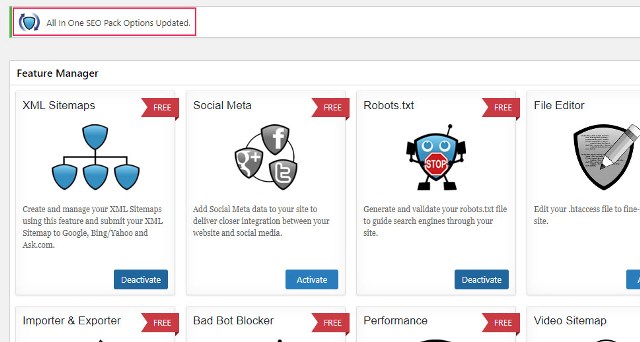

После установки плагина нажмите новый раздел All in One SEO в меню панели инструментов, а затем кликните на опцию Feature Manager. На странице Feature Manager найдите функцию Robots.txt и нажмите кнопку Активировать.

Файл robots.txt создан. После этого появится сообщение об успешном выполнении, в котором говорится, что параметры обновлены. И появится новый подраздел под названием Robots.txt.

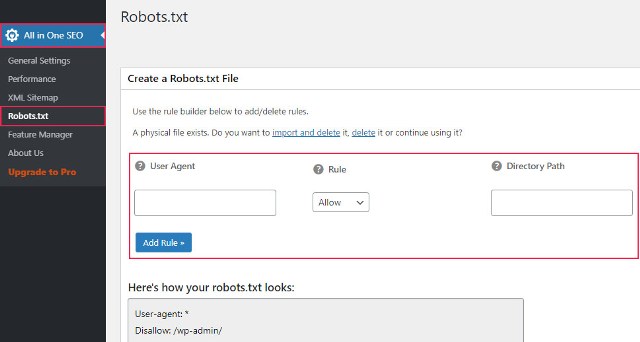

Нажав на опцию Robots.txt, откроется новый раздел. Там вы сможете добавить новые правила в robots.txt, а также посмотреть, как он выглядит в настоящее время.

Создание robots.txt через FTP

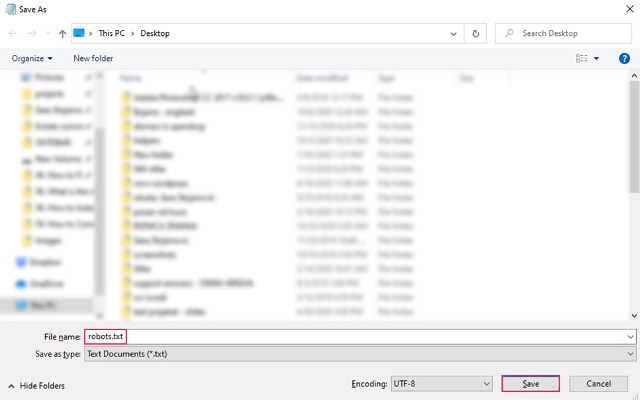

Помимо использования плагина WordPress, можно создать robots.txt вручную. Сначала создайте на своем компьютере пустой файл типа .txt и сохраните его как robots.txt.

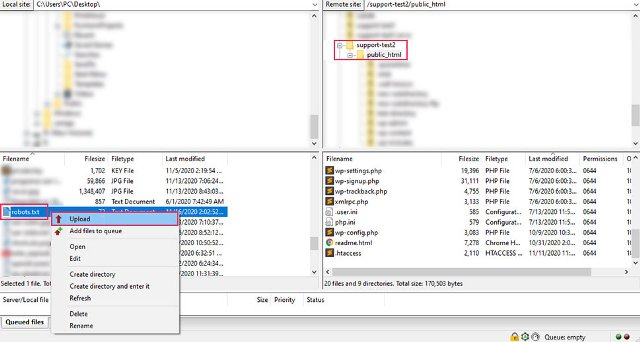

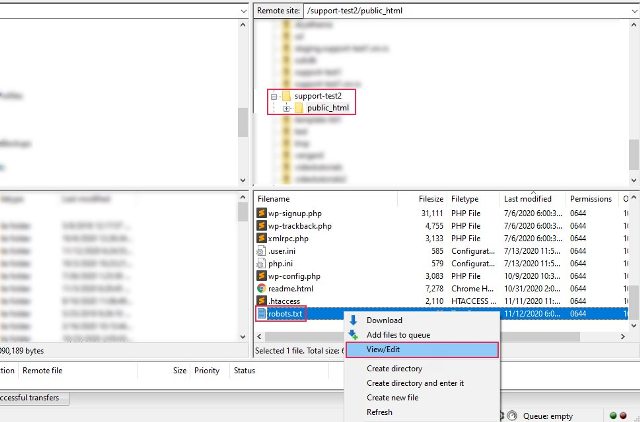

Затем подключитесь к серверу, используя свои учетные данные FTP. Затем в правом разделе перейдите в корневой каталог WordPress, который часто называется public_html. В левой части вашего FTP-клиента (в примере используем Filezilla) найдите robots.txt, который вы ранее создали и сохранили на своем компьютере. Щелкните на него правой кнопкой мыши и выберите Загрузить вариант.

Через несколько секунд файл будет загружен, и его можно увидеть среди других в корневом каталоге WordPress.

Если вы хотите впоследствии отредактировать загруженный robots.txt, найдите его в корневом каталоге WordPress, щелкните по нему правой кнопкой мыши и выберите параметр «Просмотр / редактирование».

Добавление правил в robots.txt

Теперь, когда вы знаете, как создавать и редактировать robots.txt, можем подробнее поговорить о правилах, которые может содержать этот файл. В robots.txt чаще всего присутствуют две директивы: User-agent и Disallow.

Правило User-agent указывает, к какому боту применяются директивы, перечисленные под User-agent. Вы можете указать одного бота (например, User-agent: Bingbot) или применить директивы ко всем ботам, поставив звездочку (User-agent: *).

Правило Disallow запрещает боту доступ к определенной части сайта. А еще есть правило Allow, которое делает прямо противоположное. Ее не нужно использовать так часто, как Disallow, потому что ботам по умолчанию предоставляется доступ к сайту. Allow обычно используется в сочетании с директивой Disallow. Точнее, она служит для разрешения доступа к файлу или подпапке, принадлежащей запрещенной папке.

Кроме того, есть еще две директивы: Crawl-delay и Sitemap.

Правило Crawl-delay используется для предотвращения перегрузки сервера из-за чрезмерных запросов сканирования. Однако эту директиву следует использовать с осторожностью, поскольку она не поддерживается некоторыми сканерами (например, Googlebot) и по-разному интерпретируется поисковыми роботами, которые ее поддерживают (например, BingBot).

Правило Sitemap указывает поисковым системам на ваш XML-файл карты сайта. Настоятельно рекомендуем использовать эту директиву, так как она поможет с отправкой созданной вами XML-карты сайта в Google Search Console или Bing Webmaster Tools. Но имейте в виду, что при использовании этой директивы нужно использовать абсолютный URL-адрес для ссылки на свою карту сайта (например, Sitemap: https://www.example.com/sitemap_index.xml).

Примеры фрагментов robots.txt

Ниже рассмотрим два примера фрагментов, иллюстрирующие использование директив robots.txt, упомянутых выше. Однако это только примеры; в зависимости от вашего веб-сайта может потребоваться другой набор правил. С учетом сказанного, давайте взглянем на фрагменты.

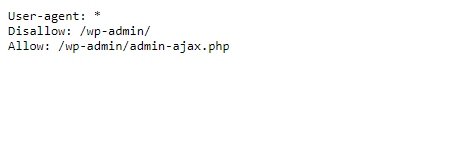

- Этот фрагмент примера запрещает доступ ко всему каталогу / wp-admin / для всех ботов, за исключением файла /wp-admin/admin-ajax.php, находящегося внутри.

User-agent: *

Disallow: / wp-admin /

Allow: /wp-admin/admin-ajax.php

- Этот фрагмент обеспечивает доступ к папке / wp-content / uploads / для всех ботов. При этом запрещает доступ к папке / wp-content / plugins /, / wp-admin / и / refer /, а также к файлу /readme.html для всех ботов. В приведенном ниже примере показан правильный способ написания нескольких правил; независимо от того, относятся они к одному или к разным типам, обязательно указывайте по одному в каждой строке. Кроме того, этот пример фрагмента позволяет ссылаться на файл карты сайта, указав его абсолютный URL. Если решите использовать его, не забудьте заменить часть www.example.com фактическим URL-адресом вашего веб-сайта.

User-agent: *

Allow: / wp-content / uploads /

Disallow: / wp-content / plugins /

Disallow: / wp-admin /

Disallow: /readme.html

Disallow: / refer /

Sitemap: https://www.example.com/sitemap_index.xml

Тестирование «robots.txt»

После добавления директив, соответствующих требованиям вашего веб-сайта, вам следует протестировать robots.txt WordPress. Таким образом, вы одновременно проверяете, что в файле нет никаких синтаксических ошибок, и убедитесь, что соответствующие области вашего веб-сайта были правильно разрешены или запрещены.

Чтобы протестировать robots.txt своего веб-сайта, перейдите на веб-сайт, посвященный SEO-тестированию. Затем вставьте любой URL вашего сайта (URL домашней страницы, например), выберите User-agent (Googlebot, например), и нажмите кнопку Test.

Если URL-адрес доступен для сканирования, то увидите зеленый результат с надписью Разрешено. В противном случае будет отображаться сообщение «Запрещено». Чтобы подтвердить правильность директив сканирования на своем веб-сайте, можете повторить тот же процесс для любого количества разных URL-адресов.

robots.txt – это текстовый файл, расположенный в корневом каталоге каждого сайта WordPress. Он содержит директивы для поисковых роботов, сообщающие им, какие части веб-сайта следует сканировать, а какие нет. Хотя этот файл по умолчанию является виртуальным, знание того, как создать его самостоятельно, будет полезным для поисковой оптимизации.

Поэтому мы рассмотрели различные способы создания физической версии и поделились инструкциями по ее редактированию, коснулись основных директив, которые должен содержать robots.txt WordPress, и того, как проверить правильность их установки.

Источник: qodeinteractive.com

Комментарии к записи: 1

Мой robots.txt

Может кому пригодится:

User-agent: *

Allow: /wp-*/*.css

Allow: /wp-*/*.js

Allow: /wp-*/*.jpg

Allow: /wp-*/*.png

Allow: /wp-*/*.gif

Allow: /wp-*/*.woff

Disallow: /author/

Disallow: /wp-

Disallow: /readme

Disallow: /search

Disallow: *?s=

Disallow: *&s=

Disallow: */reviews/

Disallow: */attachment/

Disallow: */embed

Disallow: */page/

Disallow: *ycl=

Disallow: *gcl=

Disallow: *cpa=

Disallow: *utm=

Disallow: *clid=

Disallow: *openstat=

Sitemap: https://domen.ru/sitemap.xml